دراسة جامحة تقترح أن الذكاء الاصطناعي يمكن أن يشرح سبب عدم لقائنا بأي كائنات فضائية

يجعل الذكاء الاصطناعي وجوده محسوسًا بآلاف الطرق المختلفة. ويساعد العلماء على فهم مجموعات هائلة من البيانات، ويساعد على كشف الاحتيال المالي، ويقود سياراتنا، ويغذينا بالاقتراحات الموسيقية، وتدفعنا روبوتات الدردشة للجنون. وقد بدأ الأمر للتو.

هل نحن قادرون على فهم مدى سرعة استمرار الذكاء الاصطناعي في التطور؟ وإذا كانت الإجابة لا، فهل يشكل ذلك المرشح العظيم (Great Filter)؟

إنًّ مفارقة فيرمي هي التناقض بين الاحتمال الكبير الواضح للحضارات المتقدمة الموجودة والنقص التام في الأدلة على وجودها. اُقْتُرِحَ الكثير من الحلول لسبب وجود التناقض، و”المرشح العظيم” هي إحدى الأفكار.

المرشح العظيم هو حدث أو موقف مفترض يمنع الحياة الذكية من أن تصبح بين الكواكب وبين النجوم بل ويؤدي إلى زوالها. فكر في تغير المناخ أو الحرب النووية أو ضربات الكويكبات أو انفجارات المستعر الأعظم أو الأوبئة أو أي عدد من الأشياء الأخرى من معرض المارق للأحداث الكارثية.

أو ماذا عن التطور السريع للذكاء الاصطناعي؟

تستكشف ورقة بحثية جديدة في Acta Astronautica فكرة أن الذكاء الاصطناعي يصبح ذكاء اصطناعيًا فائقًا (ASI) وأن ASI هي المرشح العظيم. عنوان الصحيفة: «هل الذكاء الاصطناعي هو المرشح العظيم الذي يجعل الحضارات التقنية المتقدمة نادرة في الكون؟»، والمؤلف هو مايكل جاريت من قسم الفيزياء وعلم الفلك في جامعة مانشستر.

“بدون تنظيم عملي، هناك كل الأسباب للاعتقاد بأن الذكاء الاصطناعي يمكن أن يمثل تهديدًا كبيرًا للمسار المستقبلي ليس فقط لحضارتنا التقنية ولكن لجميع الحضارات التقنية”.

مايكل جاريت، جامعة مانشستر

ويعتقد البعض أن المرشح العظيم يمنع الأنواع التكنولوجية مثل نوعنا من أن تصبح متعددة الكواكب. وهذا سيء لأن الأنواع أكثر عرضة للانقراض أو الركود بمنزل واحد فقط. ووفقًا لغاريت، فإن نوعًا ما في سباق مع الزمن بدون كوكب احتياطي.

كتب غاريت: «يُقترح أن يظهر مثل هذا المرشح قبل أن تتمكن هذه الحضارات من تطوير وجود مستقر متعدد الكواكب، مما يشير إلى أن طول العمر النموذجي للحضارة التقنية أقل من 200 عام».

وإذا كان هذا صحيحًا، فيمكن أن يفسر ذلك سبب عدم اكتشافنا للبصمات التقنية أو أي دليل آخر على ETIs (الذكاء خارج كوكب الأرض). ماذا يخبرنا ذلك عن مسارنا التكنولوجي؟ إذا واجهنا قيدًا لمدة 200 عام، وإذا كان ذلك بسبب ASI، فأين يتركنا ذلك؟

ويؤكد غاريت على: «الحاجة الماسة إلى إنشاء أطر تنظيمية بسرعة لتطوير الذكاء الاصطناعي على الأرض والنهوض بمجتمع متعدد الكواكب للتخفيف من مثل هذه التهديدات الوجودية».

ويقول الكثير من العلماء والمفكرين الآخرين إننا على أعتاب تحول هائل. لقد بدأ الذكاء الاصطناعي للتو في تغيير طريقة قيامنا بالأشياء؛ الكثير من التحول وراء الكواليس. ويبدو أن الذكاء الاصطناعي مستعد لإلغاء الوظائف للملايين، وعندما يقترن بالروبوتات، يبدو التحول غير محدود تقريبًا. هذا مصدر قلق واضح إلى حد ما.

لكن هناك مخاوف أعمق وأكثر منهجية. من يكتب الخوارزميات؟ هل سيميز الذكاء الاصطناعي بطريقة ما؟ من شبه المؤكد. هل ستقوض الخوارزميات المتنافسة المجتمعات الديمقراطية القوية؟ هل ستبقى المجتمعات المفتوحة مفتوحة؟ هل ستبدأ ASIفي اتخاذ القرارات نيابة عنا، ومن سيكون مسؤولاً إذا فعلت ذلك؟

هذه شجرة متسعة من الأسئلة المتفرعة بدون نهاية واضحة.

لقد حذر ستيفن هوكينج (RIP) الشهير من أن الذكاء الاصطناعي يمكن أن ينهي البشرية إذا بدأ في التطور تطورًا مستقلًا.

وقال لمجلة Wiredفي عام 2017: “أخشى أن يحل الذكاء الاصطناعي محل البشر تمامًا. إذا صمم الناس فيروسات الكمبيوتر، فسيصمم شخص ما ذكاءً اصطناعيًا يحسن نفسه ويكرره. وسيكون هذا شكلًا جديدًا من أشكال الحياة يتفوق على البشر”. وبمجرد أن يتفوق الذكاء الاصطناعي على البشر، يصبح ASI.

وقد يكون هوكينج أحد أكثر الأصوات شهرةً ممن أصدروا تحذيرات بشأن الذكاء الاصطناعي، لكنه بعيد كل البعد عن كونه الصوت الوحيد. وسائل الإعلام مليئة بالمناقشات والتحذيرات، إلى جانب مقالات حول العمل الذي ينفذه الذكاء الاصطناعي لنا. تقول التحذيرات الأكثر إثارة للقلق أن ASI قد تصبح مارقة. ويرفض بعض الناس ذلك باعتباره خيالًا علميًا، لكن غاريت لا يرفض.

كتب غاريت: «المخاوف بشأن تحول الذكاء الاصطناعي (ASI) في النهاية إلى المارقة تعد قضية رئيسية، مكافحة هذا الاحتمال على مدى السنوات القليلة المقبلة هي بحث متزايد للقادة في هذا المجال».

إذا لم يقدم الذكاء الاصطناعي أي فوائد، فستكون المشكلة أسهل بكثير. ولكنه يوفر جميع أنواع الفوائد، من تحسين التصوير الطبي والتشخيص إلى أنظمة النقل الأكثر أمانًا. والحيلة بالنسبة للحكومات هي السماح للفوائد بالازدهار مع الحد من الضرر.

ويكتب غاريت: “هذا هو الحال خصوصًا في مجالات مثل الأمن القومي والدفاع، إذ يجب أن تكون التنمية المسؤولة والأخلاقية ذات أهمية قصوى”.

والمشكلة هي أننا وحكوماتنا غير مستعدين. لم يكن هناك أي شيء مثل الذكاء الاصطناعي، وبغض النظر عن الطريقة التي نحاول بها تصورها وفهم مسارها، فإننا نُتْرَك راغبين بذلك.

وإذا كنا في هذا الوضع، فكذلك سيكون أي نوع بيولوجي آخر يطور الذكاء الاصطناعي. يمكن أن يكون ظهور الذكاء الاصطناعي ثم ASI عالميًا، مما يجعله مرشحًا للمرشح العظيم.

هذا هو الخطر الذي تشكله ASI بعبارات ملموسة: قد لا يحتاج الحياة البيولوجية التي خلقته.

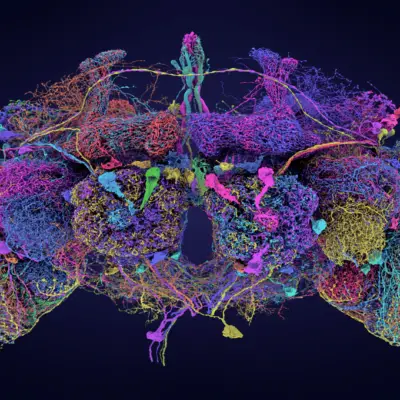

“عند الوصول إلى التفرد التكنولوجي، ستتجاوز أنظمة ASIبسرعة الذكاء البيولوجي وتتطور بوتيرة تفوق تمامًا آليات الرقابة التقليدية، ما يؤدي إلى عواقب غير متوقعة وغير مقصودة من غير المرجح أن تتماشى مع المصالح أو الأخلاقيات البيولوجية”، يشرح غاريت.

كيف يمكن ل ASIأن تخفف من الحياة البيولوجية المزعجة التي تحيط بها؟ يمكن أن يهندس فيروسًا قاتلًا، ويمكن أن يمنع إنتاج الأغذية الزراعية وتوزيعها، ويمكن أن يجبر محطة للطاقة النووية على الذوبان، ويمكن أن يبدأ الحروب.

ونحن لا نعرف حقا لأنها كلها منطقة مجهولة. ومنذ مئات السنين، كان رسامو الخرائط يرسمون الوحوش على المناطق غير المستكشفة من العالم، وهذا ما نفعله الآن.

إذا كان كل هذا يبدو بائسًا ولا مفر منه، يقول غاريت إنه ليس كذلك.

ويعتمد تحليله حتى الآن على ASI والبشر الذين يشغلون المساحة نفسها. ولكن إذا تمكنا من الوصول إلى حالة الكواكب المتعددة، فإن التوقعات تتغير.

كتب غاريت: «على سبيل المثال، يمكن للأنواع البيولوجية متعددة الكواكب الاستفادة من التجارب المستقلة على الكواكب المختلفة، وتنويع استراتيجيات البقاء الخاصة بها وربما تجنب فشل النقطة الواحدة الذي تواجهه الحضارة المرتبطة بالكواكب».

وإذا تمكنا من توزيع المخاطر عبر كواكب متعددة حول نجوم متعددة، فيمكننا حماية أنفسنا من أسوأ النتائج الممكنة ل ASI. وكتب: “نموذجه الموزع للوجود يزيد من مرونة الحضارة البيولوجية في مواجهة الكوارث التي يسببها الذكاء الاصطناعي من خلال خلق التكرار”.

وإذا فشل أحد الكواكب أو البؤر الاستيطانية التي يحتلها البشر في المستقبل في النجاة من التفرد التكنولوجي ل ASI، فقد ينجو آخرون، وسيتعلمون منه.

وقد تفعل حالة الكواكب المتعددة أكثر من مجرد النجاة من ASI؛ يمكن أن يساعدنا في إتقانه. ويتخيل غاريت المواقف التي يمكننا فيها تجربة أكثر شمولاً مع الذكاء الاصطناعي مع الاحتفاظ به. تخيل الذكاء الاصطناعي على كويكب معزول أو كوكب قزم، يقوم بعطاءاتنا دون الوصول إلى الموارد المطلوبة للهروب من سجنه.

“إنه يسمح ببيئات معزولة حيث يمكن دراسة تأثيرات الذكاء الاصطناعي المتقدم دون الخطر المباشر للإبادة العالمية”، كتب غاريت.

لكن ها هو اللغز. يسير تطوير الذكاء الاصطناعي بوتيرة متسارعة، في حين أن محاولاتنا لنصبح متعددين الكواكب ليست كذلك.

كتب غاريت أن التفاوت بين التقدم السريع للذكاء الاصطناعي والتقدم البطيء في تكنولوجيا الفضاء صارخ.

والفرق هو أن الذكاء الاصطناعي حسابي ومعلوماتي، لكن السفر إلى الفضاء يحتوي على عدة عقبات مادية لا نعرف حتى الآن كيفية التغلب عليها. وتقيد طبيعتنا البيولوجية السفر إلى الفضاء، لكن لا توجد عقبة من هذا القبيل تقيد الذكاء الاصطناعي.

ويكتب غاريت: «بينما يمكن للذكاء الاصطناعي نظريًا تحسين قدراته الخاصة دون قيود مادية تقريبًا، يجب أن يتعامل السفر إلى الفضاء مع قيود الطاقة، وحدود علوم المواد، والحقائق القاسية لبيئة الفضاء».

وفي الوقت الحالي، يعمل الذكاء الاصطناعي ضمن القيود التي وضعناها. لكن قد لا يكون هذا هو الحال دائمًا. لا نعرف متى يمكن أن يصبح الذكاء الاصطناعي ASIأو حتى إذا كان ذلك ممكنًا. لكن لا يمكننا تجاهل الاحتمال. وهذا يؤدي إلى استنتاجين متشابكين.

إذا كان غاريت على حق، فيجب على البشرية العمل بجد أكبر في السفر إلى الفضاء. وقد يبدو الأمر بعيد المنال، لكن الأشخاص المطلعين يعرفون أنه صحيح: الأرض لن تكون صالحة للسكن إلى الأبد. وستموت البشرية هنا بيدنا أو بيد الطبيعة إذا لم نتوسع في الفضاء. وتقدير غاريت لمدة 200 عام يضع علامة تعجب عليه. ويوفر التركيز المتجدد على الوصول إلى القمر والمريخ بعض الأمل.

ويتعلق الاستنتاج الثاني بتشريع الذكاء الاصطناعي وحكمه، وهي مهمة صعبة في عالم يمكن فيه للمرضى النفسيين السيطرة على دول بأكملها ويصممون على شن حرب.

كتب غاريت: “في حين يُحَذِرُ أصحاب المصلحة في الصناعة وصانعي السياسات والخبراء الأفراد وحكوماتهم بالفعل من أن التنظيم ضروري، فإن إنشاء إطار تنظيمي يمكن أن يكون مقبولاً عالميًا سيكون أمرًا صعبًا”.

بالكاد يصفها التحدي. الشجار الداخلي للبشرية يجعل الأمر أكثر صعوبة. أيضًا، بغض النظر عن مدى سرعة تطوير الإرشادات، قد تتغير ASI بسرعة أكبر.

كتب غاريت: «بدون تنظيم عملي، هناك كل الأسباب للاعتقاد بأن الذكاء الاصطناعي يمكن أن يمثل تهديدًا كبيرًا للمسار المستقبلي ليس فقط لحضارتنا التقنية ولكن لجميع الحضارات التقنية».

إذا فعلنا ذلك، فقد يتعلق الأمر بما يمكن أن يبدو مملًا ويحدث في يوم العمل: الجدل حول التشريع.

وكتب غاريت: «إن استمرار الحياة الذكية والواعية في الكون يمكن أن يتوقف على التنفيذ الفعال وفي الوقت المناسب لمثل هذه الإجراءات التنظيمية الدولية والمساعي التكنولوجية».

- ترجمة: ديمة صالح

- تدقيق علمي ولغوي: رنا حسن السوقي

- المصادر: 1