قد تُستخدم معلوماتك الشخصية لتدريب نماذج ذكاء اصطناعي مبتكرة

تدرب الشركات نماذج ذكاء اصطناعي مبتكرة على مساحات واسعة من الإنترنت، ولا توجد وسيلة حقيقية لإيقافها.

الفنانون والكتاب غاضبون بشأن أنظمة الذكاء الاصطناعي التوليدية، وهذا أمر مفهوم. إن نماذج التعلم الآلي هذه قادرة فقط على إنتاج الصور والنصوص لأنها تم تدريبها على جبال من الأعمال الإبداعية لأشخاص حقيقيين، ومعظمها محمي بحقوق الطبع والنشر.

يواجه مطورو الذكاء الاصطناعي الرئيسيون بما في ذلك OpenAI وMeta وStability الذكاء الاصطناعي الآن دعاوى قضائية متعددة في هذا الشأن. وتدعم هذه المطالبات القانونية تحليلات مستقلة؛ في أغسطس، على سبيل المثال، ذكرت مجلة أتلانتيك أن Meta دربت نموذجها اللغوي الكبير (LLM) جزئيا على مجموعة بيانات تسمى Books3، والتي تحتوي على أكثر من 170،000 كتاب مقرصن ومحمي بحقوق الطبع والنشر.

وتشمل مجموعات بيانات التدريب لهذه النماذج أكثر من مجرد كتب. في ظل الاندفاع لبناء وتدريب نماذج الذكاء الاصطناعي المتزايدة الحجم، اكتسح المطورون الكثير من مواقع الإنترنت القابلة للبحث.

ولا يؤدي هذا إلى انتهاك حقوق الطبع والنشر فحسب، بل يهدد أيضًا خصوصية مليارات الأشخاص الذين يشاركون المعلومات عبر الإنترنت. ويعني ذلك أيضًا أنه يمكن تدريب النماذج التي يفترض أنها محايدة على البيانات المتحيزة. إن الافتقار إلى شفافية الشركات يجعل من الصعب معرفة المكان الذي تحصل فيه الشركات على بيانات التدريب الخاصة بها، ولكن تحدثت مجلة ساينتفيك أمريكان مع بعض خبراء الذكاء الاصطناعي الذين لديهم فكرة عامة.

من أين تأتي بيانات التدريب الذكاء الاصطناعي؟

لبناء نماذج ذكاء اصطناعي كبيرة ومولدة، يلجأ المطورون إلى الإنترنت المواجه للجمهور. ولكن “لا يوجد مكان واحد يمكنك الذهاب إليه لتنزيل الإنترنت”، كما تقول إيميلي إم بندر، عالمة اللغوياتوالتي تدرس اللغويات الحاسوبية وتكنولوجيا اللغة في جامعة واشنطن.

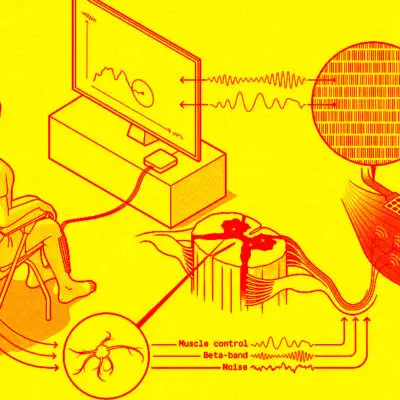

وبدلاً من ذلك، يجمع المطورون مجموعات التدريب الخاصة بهم من خلال أدوات آلية تقوم بفهرسة البيانات واستخراجها من الإنترنت. تنتقل “برامج الزحف” على الويب من رابط إلى رابط لفهرسة موقع المعلومات في قاعدة البيانات، بينما تقوم “برامج تجريف” الويب بتنزيل نفس المعلومات واستخراجها.

يمكن لشركة ذات موارد جيدة للغاية، مثل الشركة المالكة لجوجل، Alphabet، التي تبني بالفعل برامج زحف الويب لتشغيل محرك البحث الخاص بها، أن تختار استخدام أدواتها الخاصة لهذه المهمة، كما يقول باحث التعلم الآلي جيسي دودج من معهد ألين غير الربحي للذكاء الاصطناعي. ومع ذلك، تلجأ شركات أخرى إلى الموارد الحالية مثل Common Crawl، التي ساعدت في تغذية GPT-3 من OpenAI، أو قواعد البيانات مثل الشبكة المفتوحة للذكاء الاصطناعي على نطاق واسع (LAION)، والتي تحتوي على روابط للصور والتعليقات التوضيحية المصاحبة لها.

لم تستجب Common Crawl ولا LAION لطلبات التعليق. يمكن للشركات التي ترغب في استخدام LAION كمورد الذكاء الاصطناعي (كان جزءا من مجموعة التدريب لمولد الصور Stable Diffusion، كما يقول دودج) اتباع هذه الروابط ولكن يجب عليها تنزيل المحتوى بأنفسهم.

يمكن لبرامج زحف الويب وبرامج التجريف الوصول بسهولة إلى البيانات من أي مكان تقريبا ليس خلف صفحة تسجيل الدخول. لا يتم تضمين ملفات تعريف الوسائط الاجتماعية التي تم تعيينها إلى خاص. لكن البيانات التي يمكن عرضها في محرك بحث أو بدون تسجيل الدخول إلى موقع، مثل ملف تعريف LinkedIn العام، قد تظل فارغة، كما يقول دودج. كما يضيف: “هناك أنواع من الأشياء التي تنتهي تمامًا في جرف الويب هذا” بما في ذلك المدونات وصفحات الويب الشخصية ومواقع الشركة.

وهذا يشمل أي شيء على موقع مشاركة الصور الشهير فليكر، والأسواق عبر الإنترنت، وقواعد بيانات تسجيل الناخبين، وصفحات الويب الحكومية، وويكيبيديا، وريديت، ومستودعات الأبحاث، ومنافذ الأخبار والمؤسسات الأكاديمية. بالإضافة إلى ذلك، هناك مجموعات محتوى مقرصن وأرشيفات ويب، والتي غالبا ما تحتوي على بيانات تمت إزالتها منذ ذلك الحين من موقعها الأصلي على الويب. وقواعد البيانات المسروقة لا تختفي. “إذا كان هناك نص تم جرفه من موقع ويب عام في عام 2018، فسيكون ذلك متاحا إلى الأبد، سواء تمت إزالة [الموقع أو المنشور] أم لا”، يلاحظ دودج.

حتى أن بعض برامج زحف البيانات وبرامج التجريف قادرة على تجاوز جدران الدفع (بما في ذلك Scientific American) من خلال التنكر خلف الحسابات المدفوعة، كما يقول بن تشاو، عالم الكمبيوتر في جامعة شيكاغو. يقول تشاو: “ستندهش من مدى استعداد هؤلاء الزواحف ومدربي النماذج للذهاب للحصول على مزيد من البيانات”. كانت المواقع الإخبارية غير المدفوعة من بين أفضل مصادر البيانات المدرجة في قاعدة بيانات C4 من Google (المستخدمة لتدريب LLM T5 من Google وLLaMA من Meta)، وفقا لتحليل مشترك أجرته واشنطن بوست ومعهد ألين.

يمكن لبرامج تجريف الويب أيضا جمع أنواع مدهشة من المعلومات الشخصية ذات الأصول غير الواضحة. يشير تشاو إلى مثال صارخ بشكل خاص حيث اكتشفت فنانة أن صورة طبية تشخيصية خاصة لنفسها قد تم تضمينها في قاعدة بيانات LAION.

أكدت التقارير الواردة من Ars Technica رواية الفنان وأن مجموعة البيانات نفسها تحتوي على صور سجلات طبية لآلاف الأشخاص الآخرين أيضًا. من المستحيل أن نعرف بالضبط كيف انتهى الأمر بتضمين هذه الصور في LAION، لكن تشاو يشير إلى أن البيانات تصبح في غير محلها، وغالبا ما تكون إعدادات الخصوصية متساهلة، والتسريبات والانتهاكات شائعة. المعلومات غير المخصصة للإنترنت العام ينتهي بها الأمر هناك طوال الوقت.

بالإضافة إلى البيانات من هذا الجرف على شبكة الإنترنت، قد تدمج الشركات الذكاء الاصطناعي عن قصد مصادر أخرى – بما في ذلك بياناتها الداخلية – في تدريب النماذج الخاصة بها. تقوم OpenAI بضبط نماذجها بناء على تفاعلات المستخدم مع روبوتات الدردشة الخاصة بها.

وقالت ميتا إن أحدث ذكاء اصطناعي لها تم تدريبها جزئيا على منشورات فيسبوك وإنستغرام العامة. وفقا ل إلون ماسك، تخطط منصة التواصل الاجتماعي X (المعروفة سابقا باسم Twitter) لفعل الشيء نفسه مع محتوى مستخدميها. تقول أمازون أيضًا إنها ستستخدم البيانات الصوتية من محادثات أليكسا للعملاء لتدريب LLM الجديد.

ولكن بعيدًا عن هذه الاعترافات، أصبحت الشركات حذرة بشكل متزايد بشأن الكشف عن تفاصيل مجموعات البيانات الخاصة بها في الأشهر الأخيرة. على الرغم من أن Meta قدمت تفصيلا عاما للبيانات في ورقتها الفنية حول الإصدار الأول من LLaMA، إلا أن إصدار LLaMA 2 بعد بضعة أشهر تضمن معلومات أقل بكثير. لم تحدد Google أيضًا مصادر بياناتها في نموذج PaLM2 الذكاء الاصطناعي الذي تم إصداره مؤخرًا، بخلاف القول إنه تم استخدام بيانات أكثر بكثير لتدريب PaLM2 مقارنة بتدريب الإصدار الأصلي من PaLM. كتبت OpenAI أنها لن تكشف عن أي تفاصيل حول مجموعة بيانات التدريب الخاصة بها أو طريقة GPT-4، مشيرة إلى المنافسة باعتبارها مصدر قلق رئيسي.

لماذا تعتبر بيانات التدريب المراوغة مشكلة؟

يمكن لنماذج الذكاء الاصطناعي أن تقدم نفس المواد التي تم استخدامها لتدريبهم – بما في ذلك البيانات الشخصية الحساسة والعمل المحمي بحقوق الطبع والنشر. تحتوي العديد من نماذج الذكاء الاصطناعي التوليدية المستخدمة على نطاق واسع على كتل تهدف إلى منعها من مشاركة معلومات التعريف عن الأفراد، لكن الباحثين أظهروا مرارًا وتكرارًا طرقًا للالتفاف على هذه القيود.

بالنسبة للعاملين المبدعين، حتى عندما لا تكون مخرجات الذكاء الاصطناعي مؤهلة تمامًا للسرقة الأدبية، يقول تشاو إن بإمكانهم الاستفادة من الفرص المدفوعة من خلال، على سبيل المثال، استخدام التقنيات البصرية الفريدة لفنان معين. ولكن بدون الشفافية بشأن مصادر البيانات، من الصعب إلقاء اللوم على مثل هذه المخرجات على تدريب الذكاء الاصطناعي. بعد كل شيء، يمكن أن يكون من قبيل صدفة “هلوسة” المواد الإشكالية.

يثير الافتقار إلى الشفافية حول بيانات التدريب أيضا قضايا خطيرة تتعلق بتحيز البيانات، كما تقول ميريديث بروسارد، صحفية البيانات التي تبحث في الذكاء الاصطناعي في جامعة نيويورك.

وتقول: “نعلم جميعا أن هناك أشياء رائعة على الإنترنت، وهناك مواد شديدة السمية على الإنترنت”. تتضمن مجموعات البيانات مثل Common Crawl، على سبيل المثال، مواقع الويب المتعصبة للبيض وخطاب الكراهية. حتى مصادر البيانات الأقل تطرفا تحتوي على محتوى يروج للصور النمطية. بالإضافة إلى ذلك، هناك الكثير من المواد الإباحية على الإنترنت. نتيجة لذلك، يشير بروسارد إلى أن مولدات الصور الذكاء الاصطناعي تميل إلى إنتاج صور جنسية للنساء. تقول: “إنه تحيز في الداخل، وانحياز”.

يردد بندر هذا القلق ويشير إلى أن التحيز أعمق من ذلك – وصولا إلى من يمكنه نشر المحتوى على الإنترنت في المقام الأول. وتقول: “سيؤدي ذلك إلى انحراف الأثرياء، وانحراف الغرب، والانحراف نحو فئات عمرية معينة، وما إلى ذلك”. ويضيف بندر أن التحرش عبر الإنترنت يضاعف المشكلة من خلال إجبار الفئات المهمشة على الخروج من بعض المساحات على الإنترنت. هذا يعني أن البيانات المستخرجة من الإنترنت تفشل في تمثيل التنوع الكامل للعالم الحقيقي. يقول بندر إنه من الصعب فهم القيمة والتطبيق المناسب لتقنية غارقة في المعلومات المنحرفة، خاصة إذا لم تكن الشركات صريحة بشأن مصادر التحيز المحتملة.

كيف يمكنك حماية بياناتك من الذكاء الاصطناعي؟

لسوء الحظ، يوجد حاليا عدد قليل جدا من الخيارات للحفاظ على البيانات بشكل هادف خارج نماذج الذكاء الاصطناعي. طور تشاو وزملاؤه أداة تسمى Glaze، والتي يمكن استخدامها لجعل الصور غير قابلة للقراءة بشكل فعال لنماذج الذكاء الاصطناعي.

لكن الباحثين تمكنوا فقط من اختبار فعاليته مع مجموعة فرعية من مولدات الصور الذكاء الاصطناعي، واستخداماته محدودة. لسبب واحد، يمكنه فقط حماية الصور التي لم يتم نشرها مسبقا عبر الإنترنت. قد يكون أي شيء آخر قد تم تفريغه بالفعل في جرف الويب ومجموعات بيانات التدريب. أما بالنسبة للنص، فلا توجد أداة مماثلة.

يمكن لمالكي مواقع الويب إدراج أعلام رقمية تخبر برامج زحف الويب وبرامج التجريف بعدم جمع بيانات الموقع، كما يقول تشاو. ومع ذلك، فإن الأمر متروك لمطور برامج التجريف لاختيار الالتزام بهذه الإشعارات.

في كاليفورنيا وحفنة من الولايات الأخرى، تمنح قوانين الخصوصية الرقمية التي تم تمريرها مؤخرا المستهلكين الحق في مطالبة الشركات بحذف بياناتهم. في الاتحاد الأوروبي أيضا، يحق للأشخاص حذف البيانات. ومع ذلك، رفضت شركات الذكاء الاصطناعي حتى الآن مثل هذه الطلبات من خلال الادعاء بأن مصدر البيانات لا يمكن إثباته – أو بتجاهل الطلبات تماما – كما تقول جينيفر كينغ، باحثة الخصوصية والبيانات في جامعة ستانفورد.

حتى لو احترمت الشركات مثل هذه الطلبات وأزالت معلوماتك من مجموعة التدريب، فلا توجد استراتيجية واضحة للحصول على نموذج الذكاء الاصطناعي لإلغاء معرفة ما استوعبه سابقا، كما يقول تشاو. لسحب جميع المعلومات المحمية بحقوق الطبع والنشر أو التي يحتمل أن تكون حساسة من هذه النماذج الذكاء الاصطناعي، سيتعين على المرء إعادة تدريب الذكاء الاصطناعي بشكلٍ فعال من الصفر، الأمر الذي يمكن أن يكلف ما يصل إلى عشرات الملايين من الدولارات، كما يقول دودج.

لا توجد حاليا سياسات ذكاء اصطناعي مهمة أو أحكام قانونية تتطلب من شركات التكنولوجيا اتخاذ مثل هذه الإجراءات – وهذا يعني أنه ليس لديهم حافز للعودة إلى لوحة الرسم.

- ترجمة: دلال عليوي

- المصادر: 1