لماذا يُعتبر DeepSeek مغيرا لقواعد اللعبة؟

يشرح العلماء كيفية عمل نماذج الذكاء الاصطناعي ولماذا كانت تكاليف بنائها منخفضة جدًا.

أحدثت نماذج DeepSeek V3 وR1 ضجة كبيرة هذا الأسبوع. إليك السبب في أنها تُعتبر ذات أهمية كبيرة.

DeepSeek هو نموذج جديد للذكاء الاصطناعي مُختَرَع من الصين.

قبل أقل من أسبوعين، أطلقت شركة صينية بالكاد معروفة أحدث نموذج لها في مجال الذكاء الاصطناعي، مما أحدث تأثيرًا كبيرًا حول العالم.

ذكرت DeepSeek في ورقة بحثية منشورة على GitHub أن نموذج R1 ذو الأوزان المفتوحة حقق نتائج مشابهة أو أفضل من نماذج الذكاء الاصطناعي التي أنتجتها بعض الشركات الكبرى في وادي السيليكون مثل ChatGPT من OpenAI، وLlama من Meta، وClaude من Anthropic. والأكثر إثارة للدهشة أن هذا النموذج حقق تلك النتائج بتكلفة تدريب وتشغيل منخفضة للغاية.

كان رد الفعل في السوق حادًا للغاية: حيث أصبح DeepSeek التطبيق المجاني الأكثر تحميلًا في App Store، في حين تم خسارة تريليون دولار من قيمة الشركات التكنولوجية الأمريكية الكبرى.

خسرت Nvidia، الشركة المصنعة لرقائق H100 عالية الأداء التي يُفترض أنها ضرورية لتدريب الذكاء الاصطناعي، 589 مليار دولار من قيمتها السوقية في أكبر خسارة يومية في تاريخ السوق الأمريكي. وقالت DeepSeek إنها دربت نموذج الذكاء الاصطناعي الخاص بها دون الحاجة إلى هذه الرقائق، رغم أنها استخدمت رقائق Nvidia أقل قوة. ردت الشركات التكنولوجية الأمريكية بحالة من الذعر والغضب، حتى أن ممثلي OpenAI اقترحوا أن DeepSeek قد قامت بسرقة أجزاء من نماذجها.

يقول خبراء الذكاء الاصطناعي إن ظهور DeepSeek قلب أحد المفاهيم الأساسية التي كانت تتحكم بطريقة نمو الصناعة، حيث أظهرت أن الحجم الأكبر ليس دائمًا الأفضل.

قال كريستيان هاموند، أستاذ علوم الكمبيوتر في جامعة نورث وسترن، في رسالة بريد إلكتروني إلى Live Science: (في الواقع، إن DeepSeek تم بناؤه بأموال أقل، وموارد حوسبة أقل، ووقت أقل، ويمكن تشغيله محليًا على أجهزة أقل تكلفة، يثبت أنه بينما كان الجميع يتسابق نحو بناء نماذج أكبر وأكبر، فاتتنا الفرصة لبناء نماذج أذكى وأصغر).

لكن ما الذي يجعل نماذج DeepSeek V3 وR1 مدمرة بهذا الشكل؟

يقول العلماء إن السر يكمن في الكفاءة.

ما الذي يجعل نماذج DeepSeek فعالة؟

قال أمبوج تيواري، أستاذ الإحصاء وعلوم الكمبيوتر في جامعة ميشيغان، في حديثه إلى Live Science: “من بعض النواحي، يمكن اعتبار تقدم DeepSeek تطورًا أكثر منه ثوري. لا تزال تعمل ضمن النموذج السائد للنماذج الكبيرة جدًا (مئات المليارات من المعلمات) على مجموعات بيانات ضخمة (تريليونات من التوكنات) بميزانيات ضخم”.

إذا أخذنا ادعاءات DeepSeek كما هي، أضاف تيواري، فإن الابتكار الرئيسي في نهج الشركة هو كيفية استخدام نماذجها الكبيرة والقوية لتعمل بنفس كفاءة الأنظمة الأخرى بينما تستهلك موارد أقل.

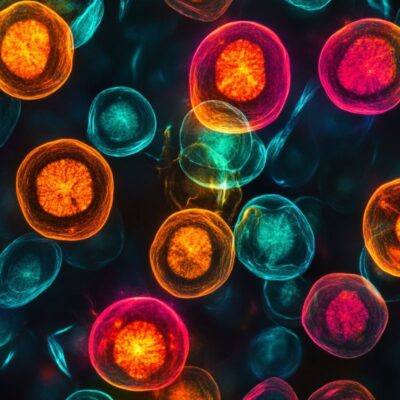

السر في ذلك يكمن في نظام (مزيج الخبراء) الذي يقسم نماذج DeepSeek إلى نماذج فرعية، كل منها متخصص في مهمة أو نوع بيانات معين. ويصاحب ذلك نظام لتحميل المهام، حيث يقوم بنقل المهام من النماذج الفرعية المثقلة إلى تلك الأقل ضغطًا بشكل ديناميكي، بدلاً من تطبيق عقوبة عامة على النظام البطيء كما تفعل الأنظمة الأخرى.

قال تيواري: “هذا يعني أنه على الرغم من أن نموذج V3 يحتوي على 671 مليار معامل، إلا أن 37 مليار فقط هي التي تُفعّل لكل وحدة نصية”. *يشير (token) إلى وحدة معالجة في نموذج اللغة الكبير (LLM)، ويعادل جزءًا من النص.

ويعزز من موازنة التحميل هذه تقنية تُسمى (توسيع الحسابات خلال وقت الاستدلال)، وهي إعداد داخل نماذج DeepSeek يقوم بزيادة أو تقليل الموارد المخصصة حسب تعقيد المهمة المعينة.

تمتد هذه الكفاءة إلى تدريب نماذج DeepSeek، حيث يعتبرها الخبراء نتيجة غير مقصودة للقيود الأمريكية على الصادرات. بسبب القيود على وصول الصين إلى رقائق Nvidia المتطورة H100، تقول DeepSeek إنها قامت ببناء نماذجها باستخدام رقائق H800، التي تتميز بمعدل نقل بيانات أقل بين الرقائق. صممت Nvidia هذه الرقاقة (الأضعف) في عام 2023 خصيصًا لتجاوز قيود التصدير.

تُحظر رقائق Nvidia H100 GPU للبيع في الصين بسبب القيود الأمريكية على الصادرات.

نوع أكثر كفاءة من نماذج اللغة الكبيرة

كان استخدام هذه الرقائق الأقل قوة هو ما دفع DeepSeek لتحقيق اختراق آخر مهم: إطار العمل المختلط الدقة. بدلاً من تمثيل جميع أوزان النموذج (الأرقام التي تحدد قوة الاتصال بين خلايا نموذج الذكاء الاصطناعي) باستخدام أرقام ذات دقة 32 بت (FP32)، قامت بتدريب أجزاء من نموذجها باستخدام أرقام ذات دقة أقل تبلغ 8 بت (FP8)، وانتقلت إلى 32 بت فقط في الحسابات الأصعب حيث تكون الدقة مهمة.

قال توماس كاو، أستاذ سياسة التكنولوجيا في جامعة تافتس، في حديثه مع Live Science: “هذا يتيح تدريبًا أسرع مع موارد حسابية أقل. كما أن DeepSeek حسّنت تقريبًا كل خطوة في عملية تدريبها – من تحميل البيانات، واستراتيجيات المعالجة المتوازية، وتحسين الذاكرة – بحيث تحقق كفاءة عالية جدًا في الواقع”.

وبالمثل، بينما من المعتاد تدريب نماذج الذكاء الاصطناعي باستخدام تصنيفات يقدمها البشر لتقييم دقة الإجابات والتفكير، يعتمد R1 على أسلوب غير إشرافي. فهو يستخدم فقط صحة الإجابات النهائية في مهام مثل الرياضيات والبرمجة كمؤشر للمكافأة، مما يتيح تخصيص موارد التدريب لمهام أخرى.

قصص ذات صلة:

•الذكاء الاصطناعي قد يجد حلولًا لمشاكل مستعصية، ولن يكون بإمكان البشر فهم النتائج.

•في دراسة “مخيفة”، خرج الذكاء الاصطناعي عن مساره أثناء التدريب ولم يمكن تعديله.

•عالم أحياء تطوري يتوقع أن الذكاء الاصطناعي قد يسبب تقلص حجم أدمغتنا.

كل هذا يساهم في جعل النماذج التي طورتها DeepSeek فعالة بشكل مدهش. بينما تتراوح تكاليف تدريب منافسي DeepSeek من عشرات الملايين إلى مئات الملايين من الدولارات وقد تستغرق عدة أشهر، يقول ممثلو DeepSeek إن الشركة قامت بتدريب نموذج V3 في شهرين فقط بتكلفة قدرها 5.58 مليون دولار.

تكاليف تشغيل V3 منخفضة أيضًا — فهي أرخص ب 21 مرة من تكلفة تشغيل نموذج Claude 3.5 Sonnet التابع لشركة Anthropic.

يحرص كاو على الإشارة إلى أن بحث وتطوير DeepSeek، والذي يتضمن الأجهزة الخاصة بها وعددًا كبيرًا من التجارب التي تعتمد على المحاولة والخطأ، يعني أنها قد أنفقت بالتأكيد أكثر من الرقم المذكور (5.58 مليون دولار). ومع ذلك، فإن هذا الانخفاض الكبير في التكاليف يعد كافيًا لإرباك منافسيها.

بشكل عام، يقول خبراء الذكاء الاصطناعي إن شعبية DeepSeek من المحتمل أن تكون إضافة إيجابية للصناعة، حيث خفضت التكاليف الباهظة للموارد ووفرت فرصة أكبر للباحثين والشركات للدخول إلى هذا المجال. كما قد تفتح المجال أمام المزيد من شركات تصنيع الرقائق غير Nvidia للمنافسة. ومع ذلك، فإن ذلك يحمل معه بعض المخاطر أيضًا.

قال كاو: “مع توافر طرق أكثر كفاءة وأقل تكلفة لتطوير نماذج الذكاء الاصطناعي المتقدمة، يمكن أن يتمكن المزيد من الباحثين في جميع أنحاء العالم من متابعة تطوير نماذج اللغة الكبيرة، مما قد يسرع التقدم العلمي وابتكار التطبيقات”. وأضاف: في الوقت نفسه، فإن انخفاض الحواجز أمام الدخول يثير تحديات تنظيمية جديدة – تتجاوز المنافسة بين الولايات المتحدة والصين – بشأن الاستخدام السيء أو التأثيرات المحتملة التي قد تؤدي إلى عدم الاستقرار بسبب الذكاء الاصطناعي المتقدم من قبل الجهات الحكومية وغير الحكومية.

- ترجمة: سهاد العمري.

- تدقيق علمي ولغوي: حسام عبدالله

- المصادر: 1